Alles hört auf mein Kommando

Alexa, Cortana, Siri oder Co-Pilot – die Computer werden nicht nur immer schlauer, sondern bekommen auch Ohren und eine Stimme. Die Experten sind sich einig, dass die Sprachsteuerung kurz vor dem großen Durchbruch steht. Das wird unser Verständnis und die Akzeptanz von digitalen Assistenzsystemen nachhaltig verändern. Im Auto, in den eigenen vier Wänden und am Arbeitsplatz werden sie uns zukünftig unterstützen.

Wer die Entwicklerkonferenzen und Produktpräsentationen der großen vier IT-Unternehmen in den vergangenen Monaten verfolgt hat, konnte erkennen, was das nächste große Ding sein wird: Sprachgestützte Assistenzsysteme sind auf dem Vormarsch. Vor 20 Jahren beherrschten die ersten Systeme vielleicht 20 Vokabeln, zehn Jahre später waren es etwa 70.000, heute sind es mehrere Millionen. Und es werden täglich mehr, bald werden die Systeme problemlos unterschiedliche Stimmen erkennen, Dialekte verstehen und in nicht ferner Zukunft auch unterschiedliche Sprachen sprechen. Apple präsentierte kürzlich seinen intelligenten Lautsprecher HomePod, Google investiert große Summen und Know-how in die Weiterentwicklung von Home, und Facebook will den Messenger für Chatbots von Firmen öffnen. Mithilfe dieser digitalen Sprachprogramme sollen Verbraucher einfacher mit Firmen in Kontakt treten können. Auch bei Microsoft hat das Thema höchste Priorität. Mit „Harman Kardon“ hat man einen Partner für hochwertige Lautsprechertechnik im Boot – denn schließlich sollen die Systeme auch gleichzeitig alle Musikanlagen im Haus überflüssig machen. Die bereits aus Windows bekannte Cortana ist bei Microsofts Lautsprecher Invoke die KI im Hintergrund. Derzeit arbeitet man wohl daran, Invoke auch mit Skype oder Office-Anwendungen zu koppeln.

Erst der Anfang, nicht das Ende

Auch der HomePod von Apple kann mit sehr guter Klangqualität und dank AppleMusik mit schier unermesslichem Inhalt punkten. Allerdings ist Siri derzeit sicherlich nicht die schlaueste künstliche Intelligenz – das weiß jeder von seinem iPhone, wenn die Antwort wieder einmal heißt: „Das habe ich nicht verstanden.“ Dass Computer sprechen, ist eigentlich nicht so unglaublich, das Bahnbrechende ist, dass sie mit uns sprechen, also Fragen verstehen und auch beantworten. Dahinter steckte immer eine künstliche Intelligenz – und die wird von Monat zu Monat schneller und intelligenter. Deep Learning und Big Data sind Nahrung für ihre virtuellen grauen Zellen. Schriftsteller und Filmemacher waren schon immer von intelligenten Computern fasziniert – meistens läuteten sie allerdings den Untergang der Menschheit ein: Skynet in Terminator oder die Herrschaft der Maschinen in Matrix. Auch HAL aus „2001 – Odyssee im Weltraum“ hat sicherlich nicht gerade für Begeisterung bezüglich sprechender und intelligenter Maschinen gesorgt. Dabei geht es auch anders: Im Star-Trek-Universum ist der „Computer“ die Schnittstelle zwischen Menschen und Maschine. Und genau darum geht es auch bei allen derzeitigen Entwicklungen. Die Steuerung ist immer nur so gut wie der Computer, der das Gesprochene versteht – damit ist nicht die akustische, sondern die inhaltliche Ebene gemeint. Über die schlaueste KI verfügt derzeit sicherlich Google. Sie speist ihre Intelligenz aus den Milliarden Anfragen, die die Suchmaschine täglich verarbeitet und analysiert. Mit Home kann man die Haustechnik steuern, im Internet suchen und Spotify streamen. Das Android-Handy fungiert dabei als optische Schalt- und Kontrollzentrale.

Mit Maschinen sprechen

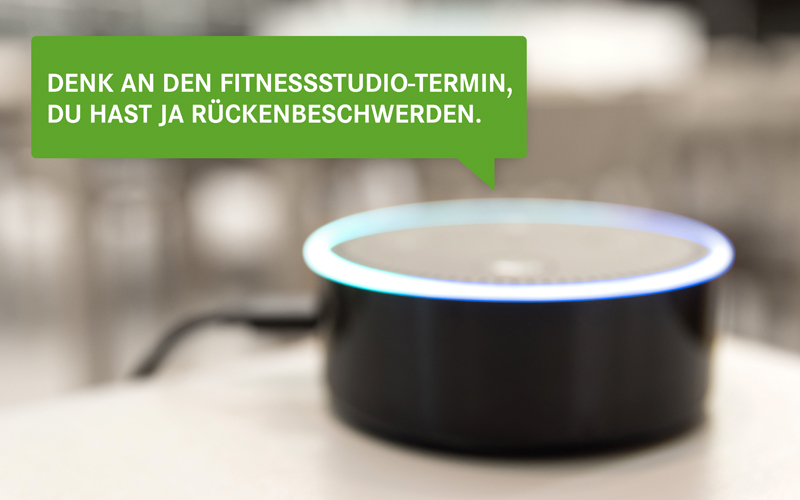

Amazon ist eher bekannt als Einkaufsplattform, trotzdem hat es mit Alexa derzeit die Nase bei intelligenten Sprachsystemen ganz vorn. Und derzeit sieht es nicht so aus, als ob jemand Amazon die Position in absehbarer Zeit streitig machen könnte. Das liegt zum einen daran, dass bereits Millionen Echo und Echo Dots – so heißt die Hardware, also die Lautsprecher, auf denen Alexa läuft – verkauft wurden. Auf der anderen Seite setzt Amazon auf eine Strategie, die bereits den Apps zum Durchbruch verholfen hat: Alexa ist offen für Anwendungen anderer Entwickler. Über 7.000 kleine Sprachprogramme, die man über Alexa steuern kann, sollen es bereits in den USA sein, hierzulande sind es erst 500, aber es werden täglich mehr: Pizza oder Taxi bestellen, Angebote der Deutschen Bahn, der Gelben Seiten oder anderer Unternehmen. Inzwischen werden bereits Produkte wie Kühlschränke oder Fernsehgeräte produziert, die von Werk aus Alexa-kompatibel sind. Die Amazon-Technologie ist dabei, sich zu der Standardschnittstelle zwischen Mensch und Maschine zu etablieren. Hinsichtlich des Internets der Dinge nur eine logische Entwicklung. Das Internet, wie es das heute noch gibt, wird es bald nicht mehr geben. Wir werden quasi im Internet leben und mit unserer Stimme werden wir unsere Umwelt steuern können. Inzwischen hat Amazon bereits mit Echo Shadow und Echo Look einen intelligenten Bildschirm und Kamera vorgestellt.

Die KI als Beifahrer

Ein weiteres Einsatzgebiet, in dem die Sprachsteuerung auf dem Vormarsch ist, ist das Auto. BMW bietet bereits seit Längerem ein System, mit dem man die Hände am Steuer behalten und gleichzeitig das Radio oder das Navi regeln oder E-Mails schreiben kann. Daimler setzt auf die Systeme von Google und Amazon, VW macht Alexa zur Mitfahrerin. Vor 30 Jahren haben wir noch über David Hasselhoff gelacht, als er mit K.I.T.T. wie mit einem Menschen gesprochen hat – bald werden Millionen K.I.T.T. über die Straßen fahren. Und natürlich macht diese Entwicklung auch nicht halt vor der Geschäftswelt: „Sprachsysteme bieten mittelfristig ein großes Potenzial für oscare®. Sie können die Beschäftigten bei der Arbeit entlasten und unterstützen. Außerdem können sie den Kundenservice nachhaltig verbessern. SAP hat jetzt mit Co-Pilot ein sehr interessantes Produkt in der Entwicklung“, erklärt Ulrich Kimpel, Produktmanager bei der AOK Systems. Co-Pilot ist ein sogenanntes „Conversational User Interface“ (CUI). Auch dahinter verbirgt sich eine selbstlernende künstliche Intelligenz, die Muster erkennen und Vorhersagen treffen kann. So wird der Co-Pilot wissen, in welchem betriebswirtschaftlichen Kontext der Mitarbeiter sich gerade bewegt, welche Daten oder Unterlagen er benötigt oder benötigen wird – und ob er etwas übersehen kann. Und darauf kann Co-Pilot dann blitzschnell aufmerksam machen oder er liefert Antworten – und dies alles ist anhand von Sprachsteuerung möglich. Das CUI soll als optionaler Teil an Fiori 2.0 angebunden werden – und hat mittelfristig das Potenzial, die Arbeit enorm zu erleichtern und zu beschleunigen.